我们听到一声惨萌惨萌的猪叫声,解救了一只被妈压住的小猪科普中国-我是科学家 2021-02-02 |

武汉疫情期间,我们通过电话总共筛查出1.4万有发热症状的人群,相当于帮医护人员把范围缩小了1000倍,可以更精准地找到这些人,提前为他们治疗。

我们听到一声惨萌惨萌的叫声。养猪户赶紧跑过去,一看,是大猪给小猪喂奶时没注意,把小猪压住了。

在公共场所的嘈杂环境下,如果需要用语音转文字,其实对手机说话时稍微隔远一点点距离,效果反而更好。

2020年11月15日,“科普中国-我是科学家”第29期“听!奇妙的声音”演讲现场,科大讯飞研究院院长助理、语音识别高级研究员孙境廷带来演讲:《让机器能听会说,我们来做一场“模仿游戏”》。

以下为孙境廷演讲实录:

2020.10.25 合肥

我是孙境廷,来自一家专注于智能语音技术的人工智能公司——科大讯飞。

我昨天坐高铁时,听见候车厅里一直在播报:“旅客朋友们你们好,开往北京南的列车马上要发车了,请您赶紧去检票。”我记得,以前高铁候车厅里还有专门的播音员,一天下来要讲很多话,嗓子会很累,但现在,我们已经可以用语音合成技术来做这件事情。

今天肯定有很多朋友开车来现场。我们上车第一件事就是打开语音导航软件,然后选一个喜欢的明星语音包。现在的导航软件里,有上千万甚至上亿的地点名称。我们不可能真让这些明星来录制,往往都是通过语音合成手段合成出来的。

我晚上睡觉前喜欢听书——现在我们在手机软件上已经不叫看书,叫听书,因为这么多文字内容都可以通过语音合成出来。比如,得到App里罗振宇的声音就是科大讯飞合成出来的。还有学习强国App里的新闻播报,每天有非常多消息推送出来,央广网的老师不可能无休无止地读,也是我们模仿了他们的声音,在软件上合成。

现在,“语音合成”已经不是新鲜事。

来之前,我翻箱倒柜,在公司数据库里找到了一段1995年的音频。当时我的老板们还是中科大的学生,这是他们在实验室里做出来的一个声音。语音质量听起来还是有点惨的。

到了1998年,语音的自然度明显高了很多,比较连贯。这一年,我们老板觉得技术做得不错,可以创业了,于是就有了科大讯飞这家公司。

从1999年起,科大讯飞一直在做智能语音的基础研究。来听听这段2016年的语音效果,确实每年都在进步。

那么,我们有没有可能把声音的效果做到和播音员一样?也就是说,我们有没有可能让机器去复制一位播音老师的声音?

央视有一位非常著名的播音员李易。你可能不熟悉这个名字,但你一定听过他的声音。“用事实说话,焦点访谈”——这句话就是李易老师的声音。

2018年,有一档央视纪录片叫《创新中国》,讲的是科技。它的导演非常喜欢李易,很想用他的声音来配音。可是,李易已经于2013年去世了。

我们就让机器学习了几十个小时的李易的声音。后来我们用李易声音配音的这部纪录片效果怎么样?我们一起来听一听——

这部纪录片播出时,很多央视的播音员、还有李易的学生都非常激动,因为能够重新听到老师的声音了。

可能会有从事播音工作的人担心,完了,以后我的工作是不是要被它替代了?实际上,我们做的事情是复刻和模仿。如果没有李易老师优美的声音作为声源让机器去学习,我们也没有办法去复刻。

既然可以让机器模仿播音员的声音,那我们有没有可能保留住亲友的声音?

2018年,就发生过一个令我们难过的故事:一位身患肺癌的父亲,想通过人工智能技术把自己的声音留存下来陪伴家人。讯飞的工作人员通过对他的音频数据进行技术处理,可以让音箱在发声时,模拟出他的声音,就像他在和家人说话。

视频中这位父亲留给儿子一个音箱,第二天一大早又坐车回老家接着治疗,再也没有回来过。但我们相信,音箱里这个声音会一直陪伴他的孩子成长。

今年(2020年)大家共同经历了疫情。1月下旬,历史上号称“九州通衢”的武汉封城。那时大家都关在家里,没有办法出去,不能互相接触。那么,在无接触情况下,如何才能最有效地联系到尽可能多的人,问问他的情况怎么样,让医护人员可以精准地找到这些人并提前给他们治疗?

我们能想到的最快的方法是打电话。我们没法让社区人员或工作人员打这么多电话,但机器可以。讯飞的机器可以在6个小时内打出100万个电话。

在武汉疫情期间,我们总共通过电话筛查出1.4万有发热症状的人。武汉有一千万人口,我们相当于帮医护人员把范围缩小了1000倍,这样就不用先挨家挨户排查,而是可以更精准地找到这些人。

刚刚视频中的电话声音就是我们通过机器合成出来的。考虑到当时的情况,我们在合成时选用了比较温柔的女声,可以给大家安抚,同时在通话过程中询问些问题,比“您还在武汉吗?”“有没有发烧的情况?”等等。

现在大家接到的很多电话外呼,几句对话内都分辨不出来是人还是机器。其中有一个比较关键的技术点,就是要让机器“能听会说”,这样才是一个完整的模仿游戏。

如何让机器听得懂人在说什么呢?甚至在刚才的视频中,这位接电话的先生还带有武汉口音,我们又该如何解决机器识别口音的问题呢?

人在发音时,其实就是肺部把一股气流冲上来变成声波,再通过口腔形状产生变化。普通话老师也会教大家,发某个音时舌头要怎么放、口形应该是什么样,通过调整口腔和声波的波形,来发出各种音。

同样,机器也可以通过麦克风来实现这种机制:麦克风上面有一个振片,就像耳朵里的鼓膜一样随声音一起振动,把声音转化成电信号。

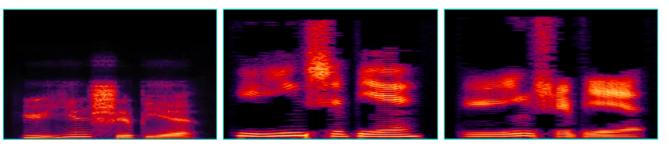

这是三个不同的人说“语音识别”这四个字的声音频谱,看起来样子差不多。我听说过去有专门研究语音的语言学专家,看了非常非常多的图片后,可以只靠看图就能大概猜到这个人说了什么字或什么话,非常厉害。

你可以大致这样理解:机器读这张图,它猜测,既然其他人说“语音识别”这四个字的时候,声音频谱都差不多是这样,那这个声音频谱对应的也是“语音识别”这四个字。

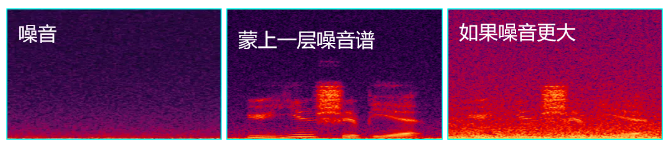

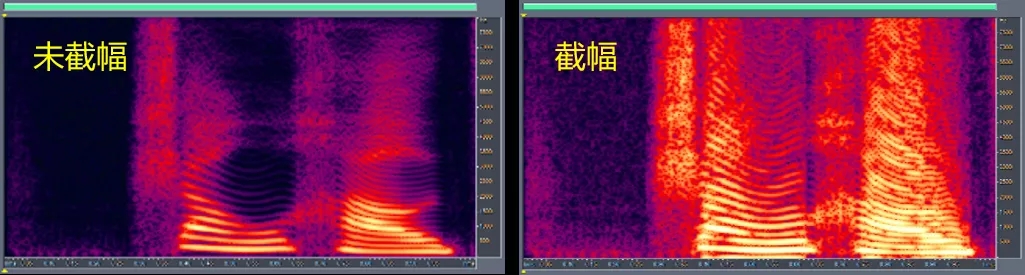

有时候情况会变得更复杂一点。比如,环境里有噪音。噪音是非常烦人的问题,就像一层灰蒙在语音上。既然机器做语音识别本质是“读图”,如果有层灰蒙在上面,就看不清了;如果噪音更大一点(比如图三),就像灰变得更厚,基本上已经看不出语音图像的原貌了。所以噪音对于语音识别来说是一个非常困难的问题。

语音识别的准确率能达到多少?现在带货的网红直播非常多,包括第一代网红罗永浩老师。其实,罗老师早在2016年就带过我们的讯飞输入法。当时在发布会上,罗永浩老师随口说了一段话,讯飞输入法一字不差识别了出来。

现在大家用微信发消息,有时也会用到“语音转文字”功能。不过,我观察到,如果周围声音比较嘈杂时,大家往往习惯把手机贴近嘴边然后用很大的声音讲话——但我今天要告诉大家,这个做法不对。

因为如果机器在读图,而我们贴它非常近,声音非常大,波形就会上去,图整体会从边缘被截掉,截掉之后机器就只能看下半部分,这样和我们原来想说的字反而更加不相似了。所以大家注意,在公共场所的嘈杂环境下,如果需要用语音转文字,其实对手机说话时稍微隔远一点点距离,效果反而更好。

现在有很多形式的考试,比如中高考的听说考试或大学四、六级英语口语考试,都是通过机器考评。所谓机器考试,并不是用机器把声音录好再让老师来听,而是让机器来评价声音。上图的考场中,屏幕背后就是我们科大讯飞人工智能的机器人,它之前听过很多声音,知道什么样的语调和发音最正确,所以也可以根据现场听到的声音来评价声音。后续如果我们发现有打分过高或过低,就会让老师再来复查或者抽检,这样就能把口语评测这件事情做得更高效。

我们洛阳研究院的同事还做过一件非常有意思的事情:用声音技术帮助养猪。

大家可能觉得现在养猪还是像以前那样,农村里面一个小猪圈围着,臭烘烘的。实际上不是,现在养猪基本上环境很好,听说还有空调。

我们把麦克风布置在养猪场的猪舍里,让它来“听”猪平时生活中的声音。正常的环境背后,一直有一些小猪哼哼唧唧的声音。

能不能听出,在很远的位置上有只小猪在咳嗽?有点像小朋友“咳咳咳”。

大家可能没听过,这是有只小猪在打喷嚏。在猪舍里,我们的机器能24小时收音,识别有没有小猪打喷嚏或者咳嗽的声音,这样就能把可能生病的症状提前一到两天判断出来,提前来投放药物,而不至于等到猪流感等疾病大范围地爆发了才发现。

我们还听到过一个非常有意思的声音:是一声惨叫,惨萌惨萌的。后来我们的养猪户赶紧跑过去,一看,发现是大猪给小猪喂奶时没注意,把小猪压住了。小猪“啊”一声叫,大猪也没有反应,继续压在那里,我们养猪户听到这个声音,赶紧去把小猪解救出来。

能听人的声音,也能听动物的声音,那之后,我们可以用讯飞的语音识别做什么?比如,如果机器也生病了,怎么办?

工业领域有非常多故障场景,现在还是需要通过老师傅的耳朵来听。因为很多设备,从外边看,还没有发生肉眼可见的问题和故障时,里面的声音已经不对了。过去,要靠有经验的老师傅或者机器巡检人员戴着非常大的耳麦去找异常声音,再通过超声波的仪器来找出准确位置。

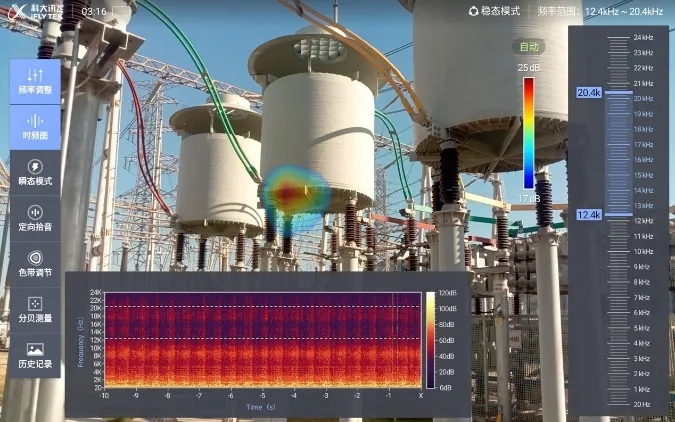

现在,我们做了这样一个仪器设备,像一个抬起来的手机一样,通过智能语音算法,就可以控制画面里异常声音的频率段,发现它的声音到底从哪里发出来。

这张局部放电的图,就是我的同事前不久在安徽省变电站拍到的。

这张图片,是机器第一个版本出来不久拍的。当时是一个夏天的下午,有一只蝉一直在我们杭州研究院外面的树上叫。我们同事想去逮它,又找不到它在哪儿,就用我们的机器一拍,发现原来在那儿。

二十年来,科大讯飞一直深耕语音技术领域。我们收集了很多人的声音,听了很多人的声音,也合成过和模仿过很多人的声音。现在我们还想做什么事情呢?我们还希望让机器也能听会说方言和外语。我们现在就在做全世界60个国家的语言,大概覆盖了200个地区的小语种。

这是讯飞机器合成出的方言和外语效果。我这个同事其实只会说普通话和英文,但是在科大讯飞这样一个声音的博物馆和语言拼图里面,因为听过了这么多声音,就可以通过机器学习,合成出更多语言的效果。

上海有一位语言科学的老师,也是我们讯飞上海研究院的领头人。她跟我们说过一个比较让人痛心的事情:我们做了非常多的方言,但同时我们也意识到一个问题,那就是世界上平均每两周就会有一种语言消失。

现在我们去北京故宫参观,还能看到满文。但现在用满文的人越来越少,它已经成了一个濒危语种。包括藏文,以及国外一些小的方言语种,随着老人故去,年轻人不说不用了,也就慢慢消失了。

讯飞上海研究院的团队,就一直在做这样的事情。比如,用人工智能抢救满文。他们曾经去拜访了满族老人何世环,先用日常语言内容建立声学基准,让机器去学习、去模仿,去了解其中的发音规律和语调变化,希望能将这样一些方言原汁原味地保留下来,也为了解这些民族的文化和历史留下最后一把钥匙。

今天演讲前,我跟张晓虹老师聊天,她告诉我,故宫里有很多满文典籍,过去正式的文献还是用原汁原味的满文来写,没有汉语版本,但现在很多满族人也只会听,已经看不懂文字了,所以,要研究这些典籍变得越来越困难。而如果我们可以通过扫描这些典籍,识别出来文字是什么,再通过技术合成出声音,也许还能知道这些典籍讲的是什么内容。

现在科大讯飞有一个“方言保护计划”,我们也希望通过这个计划让更多人参与进来,用家乡话来讲述一些自己的故事,我们一起保护和留存这些语言。

讯飞是一家蛮有意思的科技公司,我们各地的研究分院,用人工智能做了非常多有意思的事情。在研究过程中,我们也希望能为国家和社会做出更多的贡献。

演讲嘉宾孙境廷:《让机器能听会说,我们来做一场“模仿游戏”》 | 拍摄:Vphoto

责任编辑:王超

下一篇:【书摘】王立铭:疫苗的真相

科普中国APP

科普中国APP

科普中国微信

科普中国微信

科普中国微博

科普中国微博

最新文章

-

为何太阳系所有行星都在同一平面上旋转?

新浪科技 2021-09-29

-

我国学者揭示早期宇宙星际间重元素起源之谜

中国科学报 2021-09-29

-

比“胖五”更能扛!我国新一代载人运载火箭要来了

科技日报 2021-09-29

-

5G演进已开始,6G研究正进行

光明日报 2021-09-28

-

“早期暗能量”或让宇宙年轻10亿岁

科技日报 2021-09-28

-

5G、大数据、人工智能,看看现代交通的创新元素

新华网 2021-09-28